Sismologie

La sismologie ou séismologie (ce dernier est un anglicisme de l’anglais seismology [1]), étudie les séismes (tremblements de terre) et plus généralement la propagation des ondes à l’intérieur de la Terre [2].

La sismologie moderne utilise les concepts de la mécanique newtonienne appliqués à la connaissance de la Terre. Les principales disciplines sont la sismogénèse, la sismotectonique, la sismologie de l’ingénieur [3], la sismologie globale, la sismique active et la sismologie spatiale. Cette liste n’est pas exhaustive. Il existe aussi des disciplines associées où la sismologie est importante comme par exemple la paléosismologie, la mécanique des roches ou l’héliosismologie.

Histoire

Réplique du sismographe de Zhang Heng

Les tremblements de terre ont longtemps été considérés comme des messages divins.

Pour les Chinois, c’était un signe que le Ciel (les dieux) désavouait la légitimité de l’empereur. En raison de la signification politique qu’accordaient les Chinois aux séismes et à leur fréquence importante dans la région, très tôt, ils notèrent consciencieusement les différents tremblements de terre. L’un des premiers à être noté est celui de -780 et le pire en vies humaines est celui de 1556 dans la province de Shaanxi qui fit plus de 830 000 victimes [4]. Bien qu’ils n’établirent aucune théorie sur l’origine naturelle des séismes, c’est un Chinois, l’inventeur Zhang Heng, qui créa le premier pseudo-« sismographe » en 132. Utilisant le principe du pendule, ce sismographe se présentait sous la forme d’un récipient en bronze (d’environ deux mètres de diamètre), contenant un poids suspendu. Huit dragons étaient disposés tout autour du récipient, avec dans la bouche de chacun une boule. Lorsqu’une onde sismique assez importante arrivait, le pendule oscillait dans un sens, ouvrait la bouche d’un dragon et se bloquait pour ne pas déclencher le mécanisme pour un autre dragon. La boule était réceptionnée dans la bouche d’une grenouille, ainsi, il était possible de déterminer la direction dans laquelle avait eu lieu le tremblement de terre, mais non sa distance ou son intensité.

D’après la religion grecque antique, c’était Poséidon le responsable de tels évènements. Pourtant, cela n’empêchera pas des Grecs comme Thalès (VIe siècle av. J.-C.) et surtout Aristote (IVe siècle av. J.-C.), de penser que les séismes ont une origine naturelle. Selon Thalès, ce sont des éruptions d’eau chaude qui sont la cause des tremblements de terre. Selon lui, les surfaces émergés flottent sur l’eau, et des éruptions d’eau chaudes assez violentes peuvent faire bouger la terre. Pour sa part, Aristote établit sa théorie pneumatique dans laquelle le pneuma (souffle) serait la cause des séismes. Le pneuma est produit par la chaleur de la terre (dont l’origine est le feu intérieur) ou par les rayons du Soleil. Lorsque le pneuma est dirigé vers l’extérieur, il forme les vents. Mais lorsqu’il s’enfonce dans la terre et s’accumule, il produit des tremblements de terre. De par le rôle fondamental des oeuvres d’Aristote dans les sciences du moyen-âge, cette théorie restera une des principales pendant plusieurs siècles.

En Europe, à la Renaissance, l’origine naturelle est de plus en plus envisagée, plusieurs théories apparaissent. On peut citer celle de Pierre Gassendi qui, vers 1600, pensait que c’était des poches de gaz qui explosaient [5]. Ou celle de l’Abbé Pierre Bertholon de Saint-Lazare, qui, en 1779, y voyait un effet de l’électricité, lorsqu’elle s’accumulait dans le sol, provoquant un tonnerre souterrain. Ami de Benjamin Franklin et ayant travaillé sur l’électricité, il présenta un système utilisant des paratonnerres enfoncés dans la terre pour prévenir les séismes en empêchants les coups de tonnerre.

L’ampleur du tremblement de terre de Lisbonne de 1755 (magnitude estimée autour de 8,6) provoque l’une des première étude scientifique sur le sujet. Il faudra attendre 1854 pour avoir les bases de la théorie actuelle, avec la publication par Robert Mallet de la première carte sismique du monde.

Ce n’est qu’au début du XXe siècle que l’étude approfondie des séismes commence véritablement, avec le recensement à l’échelle de la planète des tremblements de terre par Alexis Perrey et Fernand de Montessus de Ballore entre autres ou encore l’identification des différentes ondes sismiques par Richard Dixon Oldham.

La sismologie est une science ancienne du point de vue de l’observation, mais que les bases scientifiques de l’étude des séismes ne furent posées que de façon très récente.

Disciplines

Sismogénèse

Schéma d’une rupture sismique à un instant donné :

1. Direction du Nord

2. Épicentre

3. Azimut de la faille

4. Pendage de la faille

5. Point de nucléation ou hypocentre

6. Plan de faille

7. Partie de la faille en mouvement

8. Front de la rupture

9. Phase de cicatrisation

10. Partie de la faille ayant déjà rompu

11. bord de la zone intéressée par le séisme

La sismogénèse étudie les mécanismes provoquant les tremblements de terre. Cette discipline essaie de comprendre non seulement ce qui se passe lors d’un tremblement de terre sur la ou les failles impliquées, mais aussi tente d’appréhender (si elles sont appréhendables) les conditions associées au déclenchement (le terme technique est nucléation) d’un tremblement de terre dans le temps et dans l’espace.

Dans sa simplification la plus extrême, la source d’un séisme peut être considérée comme un point représentant la position de la nucléation (appelée aussi foyer ou hypocentre). Le travail consistant à trouver la position de ce point est appelé localisation. Le diagramme du rayonnement d’énergie à basse fréquence d’un séisme correspond à celui d’un double couple de force dont un des deux plans nodaux correspond au plan de faille. L’orientation spatiale de ce double couple est appelé mécanisme au foyer. Ce dernier permet de savoir s’il s’agit d’une faille inverse, normale ou décrochante. La première étape de l’étude d’un séisme est donc de trouver la localisation et le mécanisme au foyer. La disponibilité des données sismologiques en temps réel à l’échelle planétaire permet d’obtenir ces informations très rapidement après un évènement (moins d’une heure pour les séismes majeurs).

Mais la source d’un tremblement de terre n’est pas un point. Les plus grands séismes sont générés par des ruptures de failles de plusieurs centaines de kilomètres. Le sismologue parle de source étendue quand il décrit le séisme non plus comme un simple point mais comme une surface bi-dimensionelle plus ou moins complexe.

La sismogénèse utilise deux types de représentation de la source sismique qui tendent petit à petit à se rejoindre. L’approche cinématique représente le séisme à partir de la différence de l’état de la faille avant et après la rupture. La source sismique est alors décrite principalement par la vitesse (et ses variations) du glissement d’un point sur la faille (de l’ordre du m.s-1) lors du séisme et par la vitesse à laquelle se propage la rupture sur cette même faille (de l’ordre de quelques km.s-1). La seconde représentation est dynamique. Cette représentation part d’un état initial de la faille qui est portée à un état critique où la rupture commence (nucléation). La rupture se développe suivant des lois constitutives (par exemple la loi reliant la vitesse de glissement au frottement). La réprésentation dynamique a sûrement plus de sens physique que la représentation cinématique mais est beaucoup plus complexe à manipuler. On peut dans la plupart des cas déduire une représentation cinématique d’une représentation dynamique (le contraire n’est pas possible).

Comprendre la source sismique est fondamental pour pouvoir un jour espérer prévoir les séismes. Certains groupes de chercheurs estiment qu’il est possible de prédire certains évènements sismiques mais ces recherches n’ont pas le consensus de toute la communauté sismologique et sont souvent l’origine de débats très enflammés.

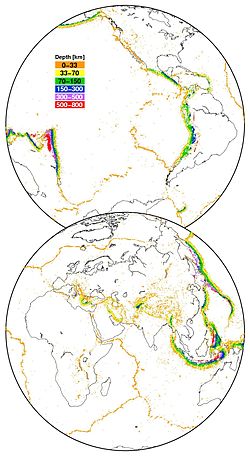

Carte de la sismicité mondiale depuis 1973. Source des données USGS-NEIC

Sismotectonique

La sismotectonique est la branche de la géologie et de la géophysique qui étudie les structures et les mouvements tectoniques grâce aux séismes, ainsi que les rapports entre les séismes et la tectonique. En effet, la distribution spatiale des tremblements de terre (sismicité) n’est pas aléatoire. En regardant la sismicité à l’échelle planétaire, la majeure partie des séismes se situe aux frontières des plaques tectoniques. La variation de la profondeur des hypocentres souligne la présence des zones de subduction.

Cette simple analyse à l’échelle du globe peut être effectuée à toutes les échelles. À l’aide de différentes stations sismiques réparties autour d’un séisme, il est possible de retrouver les paramètres physiques d’un séisme, comme les coordonnées du séisme, sa profondeur (souvent difficile à déterminer), et le mécanisme au foyer du séisme ; ainsi on détermine le type de faille mise en jeu. À partir de la simple analyse de sismogrammes ayant enregistré une secousse, il subsiste toujours un doute sur l’orientation de la faille principale, la distinction entre le plan de faille et le plan nodal (plan théorique orienté perpendiculairement au plan de faille) ne pouvant être obtenu que par la connaissance géologique et/ou l’étude des répliques du séisme principal. Les mécanismes au foyer (paramètres géométriques de la rupture) sont liés à l’orientation et aux variations du champ de contrainte dans la croûte.

La localisation précise des séismes nécessite une connaissance assez détaillée des variations de la vitesse des ondes sismiques dans le sous-sol. Ces vitesses sont directement liées aux propriétés élastiques et physiques du milieu. En général, les variations de vitesse dans la Terre sont fonction de la profondeur. Ceci est la raison pour laquelle, en première analyse, le milieu dans lequel se propagent les ondes (milieu de propagation) est souvent assimilé à un milieu stratifié horizontal (empilement de couches horizontales, le terme technique est milieu monodimensionnel). Mais la prise en compte de milieux complexes tridimensionnels est aujourd’hui pratique courante. Ainsi la détermination du milieu de propagation et la localisation des séismes sont obtenues conjointement par des techniques de tomographie dite passive (les sources sont naturelles).

Un séisme est toujours le témoignage de la présence d’une faille (si on exclut certaines sources très particulières). Mais une faille ne produit pas toujours des séismes. On parlera alors de faille inactive si celle-ci ne cause aucune déformation. En revanche une faille, ou un segment de faille, peut être active mais ne générer aucun séisme (ou bien une sismicité diffuse de très faible magnitude). La faille est alors dite asismique. Le mouvement sur la faille se fait alors très lentement (quelques millimètres par an). Le terme technique est «creeping» (mot anglais signifiant littéralement «rampement»). Cette déformation ne peut être mise en évidence que par des données géodésiques (par exemple des mesures GPS ou des images InSAR). Ce même type de données a permis de détecter récemment des glissements sur des failles ayant des durées très longues (plusieurs semaines à plusieurs mois). Ces événements sont appelés «séismes lents» [6] [7].

La relation entre activité sismique et faille est importante pour la prévision sismique. Dans une vision simplifiée, la déformation due à la tectonique augmente les contraintes sur la faille. Arrivé à un certain seuil, une rupture se déclenche et la faille génère un séisme relâchant les contraintes accumulées. La faille est alors prête pour un nouveau cycle d’accumulation. Ainsi, sur un système de faille où la charge en contrainte est homogène, la faille ou le segment de faille n’ayant pas subi de forts tremblements de terre depuis longtemps devient un bon candidat pour le prochain séisme. Ce candidat est appelé « gap » sismique [8] [9]. Cette simplification n’est pas souvent vérifiée car le champ de contrainte n’est pas homogène et la géométrie des failles est complexe.

Aléa sismique

Carte de l’aléa sismique pour l’Europe du Nord. L’échelle des couleurs indique l’accélération du sol ayant 10% de chance d’être dépassée en 50 ans. Source GSHAP

L’analyse de l’aléa sismique étudie l’occurrence des tremblements de terre et les mouvements forts du sol qui en découlent. On distingue en général deux approches distinctes : l’analyse probabiliste de l’aléa sismique (en anglais PSHA pour Probabilistic Seismic Hazard Analysis) et l’approche déterministe [10]. Ces deux approches sont complémentaires et sont souvent utilisées ensemble.

L’approche déterministe permet de faire des études de scénario quand la plupart des paramètres du problème sont fixés. En pratique, elle permet de répondre à des demandes du type : « Quelles seraient les accélérations du sol attendues à Aix-en-Provence dans le cas d’un séisme de magnitude 6 sur la Faille de la Trévarese ? ». La réponse à cette question se base souvent sur les connaissances acquises grâce à la sismicité historique. Si le scénario est inédit et n’a pas de réponse dans les bases de données, alors une simulation numérique du problème est requise.

L’approche probabiliste fait intervenir la notion de temps et d’occurrence. Elle nécessite la connaissance de la variation du taux de sismicité sur le territoire. La demande typique est la suivante : « Quelles sont les chances de dépasser une accélération du sol de 2 m.s-2 à Aix-en-Provence dans les 50 prochaines années ? ». Cette approche permet aussi de réaliser une carte de l’aléa sismique quand la question est légèrement modifiée : « Quelle est l’accélération du sol en ce point ayant 10% de chance d’être dépassé dans les 50 prochaines années ? ».

Il est nécessaire de faire la distinction entre l’aléa sismique et le risque sismique. En effet le risque sismique est l’impact de l’aléa sismique sur l’activité humaine en général. Ainsi on parle d’un aléa sismique élevé pour une région ayant une activité sismique importante. Mais à un aléa sismique élevé ne correspond pas forcement un risque sismique élevé si la région est déserte et ne comporte pas de construction. En revanche même une zone ayant une sismicité modérée peut être considérée à haut risque du fait de densité de la population, de l’importance du construit ou bien de la présence d’édifices sensibles (centrales nucléaires, usines chimiques, dépôts de carburants, …).

Sismologie globale

La sismologie globale étudie la structure de la Terre en utilisant les enregistrements des ondes produites par les séismes à très grandes distances. En effet, quand la magnitude du séisme est suffisante (supérieure à 5), les ondes qu’il émet peuvent être mesurées sur toute la surface de la Terre.

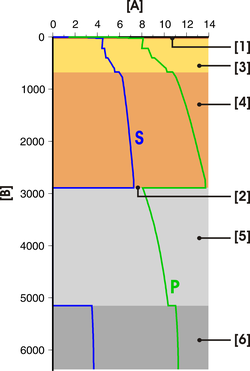

Vitesse des ondes P et S du modèle PREM.

A : Vitesse (km.s-1). B : profondeur (km). 1 : croûte. 2 : interface noyau-manteau. 3 : manteau supérieur. 4 : manteau inférieur. 5 : noyau externe. 6 : noyau interne.

Les ondes de volume, primaires et secondaires (dites ondes P et ondes S), traversent la Terre et se réfléchissent sur les discontinuités majeures (interface noyau-manteau, Moho, surface de la terre). Chaque réflexion produit différentes phases et l’étude de leur temps de parcours entre la source et le sismomètre donne des informations sur la structure traversée. Par exemple, l’absence d’onde de cisaillement S passant par le noyau externe a permis à Richard Dixon Oldham de conclure qu’il était liquide.

Le premier modèle de référence a été justement déduit de l’étude des temps de parcours des ondes sismiques. Il s’agit d’un modèle monodimensionnel [11] définissant la variation de la vitesse des ondes sismiques et de la densité en fonction de la profondeur.

Mais l’approximation de paramètres ne dépendant que de la profondeur est seulement de premier ordre. La variabilité tri-dimensionelle de la structure interne du point de vue sismologique a de multiples causes. La cause principale est l’hétérogénéité associée aux discontinuités majeures. Leur géométrie est complexe. Il s’agit aussi de zones d’échanges créant des variations importantes des paramètres physiques auxquels sont sensibles les ondes sismiques. Par exemple, l’étude des phases réfléchies à la frontière entre le noyau et le manteau fournit des informations non seulement sur sa topographie mais aussi sur son comportement, qui est très important pour la dynamique de la planète Terre. En utilisant l’outil tomographique, les dernières études montrent des images de plus en plus nettes du manteau, des zones de subduction et proposent des réponses sur l’origine des plumes mantelliques.

Les ondes de volume ne sont pas les seules à être sensibles à l’échelle du globe. Lors des grands tremblements de terre, les ondes de surfaces peuvent faire plusieurs fois le tour de la Terre. L’utilisation de ces types de données sert aussi à la connaissance de la structure de la Terre dans les premières centaines de kilomètres. En effet, l’amplitude des ondes de surface s’atténue avec la profondeur.

Enfin, la Terre est un volume fini et peut résonner. Pour les plus importants séismes, l’interaction constructive des ondes de surface faisant le tour de la Terre excite ses modes propres. La Terre se met alors à sonner comme une cloche. Le son le plus bas émis par la terre a une période d’environ 53,83 min [12]. Ce son dure plusieurs jours avant de s’atténuer. La période des différents modes est directement reliée à la structure interne de la Terre. Le modèle de référence le plus utilisé jusqu’à présent s’appelle le PREM de l’anglais Preliminary Reference Earth Model [13]. Aujourd’hui plusieurs autres modèles très légèrement différents sont aussi utilisés.

Sismique d’exploration

Les avancées de la sismique d’exploration sont intimement liées à la prospection pétrolière et à la surveillance des gisements. Toutefois, les techniques développées dans ce domaine sont aussi employées pour la connaissance de la structure en général de l’échelle du laboratoire jusqu’à l’échelle de la croûte terrestre.

Souvent cette activité est appelée aussi sismique active car les sources utilisées sont le plus souvent artificielles (du coup de marteau à l’explosion nucléaire). Il faut noter que la sismique d’exploration s’effectue de plus en plus avec des sources naturelles et/ou induites dans le cas des réservoirs.

Les configurations du dispositif source – récepteur sont fondamentales dans ce domaine. Elles vont en effet définir le type de données obtenu et donc le type de méthode à employer et le type de résultat attendu. La première distinction est la dimensionalité de l’acquisition. Elle peut être 1D (une source et plusieurs capteurs alignés ou le contraire), 2D (les sources et les récepteurs sont contenus dans un plan en général vertical), 3D et 4D (étude de la variation du problème 3D dans le temps). Chaque passage de dimension implique une augmentation substancielle du coût de l’acquisition mais aussi le coût du traitement des données et de leur interprétation.

L’autre caractéristique importante de la configuration est le type de déport (distance source – capteur) utilisé. Quand les déports sont petits, l’énergie enregistrée sur le capteur provient principalement de la réflexion de l’énergie sur les discontinuités d’impédance du milieu. on parle de sismique réflexion. Quand les déports sont grands, l’énergie enregistrée provient des phases sismiques traversant le milieu ou longeant les discontinuités (ondes réfractées). On parle alors de sismique réfraction.

Ces deux concepts sont liés surtout à la prospection en mer. Pour la sismique réflexion le bateau en progressant traine une ligne de capteurs appelée flûte tout en émettant de l’énergie (tirs) grâce à des canons à air. Dans le cas de la sismique réfraction, le capteur est fixe et le bateau s’en éloigne en tirant. Ces acquisitions sont principalement 2D ou 3D dans le sens de multi 2D. De plus en plus de prospections mélangent maintenant ces deux concepts en une seule acquisition (sismique réflexion à grand angle). L’acquisition de données à terre est beaucoup plus coûteuse et les milieux sont en général plus difficiles à interpréter.

Sismologie spatiale

Au premier plan, le sismomètre passif installé sur la Lune lors de la mission Apollo 16

La sismologie et ses outils ne sont plus confinés à la planète bleue depuis la fin des années 1960 grâce au programme Apollo. Lors de la mission Apollo 12, le premier sismomètre extra-terrestre est installé sur la Lune le 19 novembre 1969. Lors de chacun des trois atterrissages suivant (Apollo 14, 15 et 16), un sismomètre est installé. Ces instruments ont formé le premier (et unique pour le moment) réseau sismologique extra-terrestre. L’expérience prit fin le 30 septembre 1977.

Les sources sismiques enregistrées sur la lune sont de cinq types différents :

- impacts de météorites ;

- impacts artificiels ;

- sources thermiques très superficielles causées par la variation journalière de température en surface ;

- séismes superficiels haute fréquence dus au refroidissement thermique (magnitude observée jusqu’à 5 – nombre d’observations : 28) ;

- séismes profonds (appelés tremblement de Lune) (nombre : 3145) causés par la marée lunaire. Ils sont localisés entre 800 et 1200 km de profondeur.

L’analyse de ces données uniques a permis de démontrer que la structure de la Lune est différenciée (existence d’une croûte, d’un manteau et d’un hypothétique noyau). Les vitesses des ondes sismiques ont ajouté des contraintes sur la composition chimique et minéralogique, compatible avec l’hypothèse d’une collision entre deux astres. Les enregistrements des tremblements de Lune durent très longtemps (jusqu’à une heure). Cette caractéristique est expliquée par la grande dispersion (grande hétérogénéité) et par la faible atténuation dans la croûte lunaire.

Le programme Apollo ne fut pas le premier à tenter de mettre un sismomètre sur la Lune. Le programme Ranger tenta en 1962 de déposer un instrument avec les sondes Ranger 3 et 4. Malheureusement la première manqua la Lune et la seconde s’y écrasa. En ce qui concerne Mars, la sonde Viking installa avec succès un sismomètre en 1976. Un défaut de réglage de l’instrument associé aux forts vents martiens rendit ces données inexploitables. Dans le cadre de la mission Mars 96, les deux sismomètres Optimism prévue pour une installation sur Mars furent perdus avec le lanceur le 16 novembre 1996.

La sismologie a été appliquée aussi aux astres non solides. L’impact de la comète Shoemaker-Levy 9 sur Jupiter en 1994 généra des ondes sismiques de compression et des ondes de surface observables sur les images infrarouges. En outre l’étude des ondes P, de surface et de gravité observées sur le Soleil est maintenant une discipline établie qui s’appelle l’héliosismologie. Ces ondes sont générées par les mouvements convectifs turbulents à l’intérieur de l’étoile.

Les futurs programmes spatiaux parlent de nouvelles mesures sismologiques sur la Lune, d’envoyer des sismomètres sur une comète (Sonde Rosetta pour un «acomètissage» en 2016) et sur Mercure (mission BepiColombo en projet). Le premier sismomètre martien quant à lui est attendu pour 2013 avec la mission ExoMars.

Les ondes sismiques

Les tremblements de terre produisent différents types d’ondes sismiques. Ces ondes, en traversant la terre et en se réfléchissant ou se diffractant sur les discontinuités principales de propriétés physiques des roches, nous fournissent des informations utiles pour comprendre non seulement les événements sismiques mais aussi les structures profondes de la terre.

La mesure en sismologie

La mesure en sismologie est fondamentale que ce soit pour l’étude de la propagation des ondes que pour l’étude des séismes. En effet, l’étude d’un séisme passe par l’étude des processus en action sur la faille avant et pendant le séisme. Mais une observation directe de cet objet dans son ensemble n’est pas possible. La seule possibilité pour le moment est le forage mais c’est une solution très coûteuse et elle ne permet qu’une observation ponctuelle du plan de faille. Il faut donc recourir à des observations indirectes, la première étant les ondes générées par les séismes. Ces dernières peuvent être en effet enregistrées même à l’autre bout de la Terre en cas de magnitudes importantes. Ces ondes à leur passage font bouger le sol. C’est ce mouvement qui est enregistré grâce à des capteurs appelés sismomètres.

Quelques sismologues célèbres et leurs contributions

- En 1893, le lien entre séisme et faille est mis en évidence par Bunjiro Koto.

- En 1902, Giuseppe Mercalli crée une échelle d’intensité qui sera la réfèrence jusqu’à l’introduction du concept de magnitude.

- En 1906, Richard Dixon Oldham déduit que le noyau de la Terre est liquide.

- En 1909, Andrija Mohorovičić découvre une discontinuité sismique à la base de la croûte terrestre : cette discontinuité porte, en son honneur, le nom de Moho.

- Dans la première moitié du XXe siècle, Beno Gutenberg, outre ces célèbres travaux sur la magnitude, remarque que le nombre des séismes à l’échelle globale suit une loi.

- En 1935, Charles Francis Richter met au point une échelle fondée sur la magnitude (l’énergie libérée) de la secousse, et non sur son intensité (les effets ressentis ou observés). L’utilisation systématique de cette échelle, notamment par les journalistes, fait de Richter le seul sismologue largement connu du grand public.

- En 1936, la présence d’une graine solide dans le noyau de la Terre est découverte par Inge Lehmann.

- En 1966, Keiiti Aki a introduit le moment sismique.

- En 1977, Hiroo Kanamori propose une magnitude Mw basée sur le moment sismique.

|

Encyclopédie des métiers

Encyclopédie des métiers  Ajouter un métier

Ajouter un métier  Ajouter une vidéo métier

Ajouter une vidéo métier

Encyclopédie des métiers

Encyclopédie des métiers  Ajouter un métier

Ajouter un métier  Ajouter une vidéo métier

Ajouter une vidéo métier